Le véritable enjeu de la data n’est pas la collecte, mais la traduction de chiffres bruts en décisions stratégiques claires.

- Identifier et résoudre les « frictions sémantiques » entre vos équipes est le point de départ non-négociable.

- Maîtriser les biais cognitifs qui faussent systématiquement l’analyse est plus important que de posséder les derniers outils.

Recommandation : Adoptez une gouvernance des données centrée sur la clarté décisionnelle et les questions métiers, plutôt que sur le volume de chiffres collectés.

En tant que décideur, votre quotidien est probablement inondé de rapports, de tableaux de bord et de KPI. Le marketing vous présente des chiffres de croissance d’audience, tandis que le commerce déplore une baisse de la qualité des leads. Vous avez investi dans des outils puissants, on vous répète sans cesse l’injonction d’être « data-driven », et pourtant, un sentiment de brouillard persiste. Les données s’accumulent, mais les décisions claires et unanimes se font rares. Vous avez plus de chiffres que jamais, mais peut-être moins de certitudes.

La plupart des approches se concentrent sur la technologie : quel CRM choisir, comment configurer Power BI, quelle plateforme de données unifier. Ces questions sont pertinentes, mais elles adressent les symptômes plutôt que la cause profonde. Le passage de la simple collecte à l’action stratégique n’est pas, fondamentalement, un problème technique. C’est un défi humain, psychologique et méthodologique. Il ne s’agit pas de regarder plus de données, mais de regarder les bonnes données, de la bonne manière, pour enfin poser les bonnes questions.

Et si la clé n’était pas dans un nouvel outil, mais dans la manière dont vos équipes définissent un « lead » ? Si le plus grand risque n’était pas une base de données lente, mais votre propre cerveau qui vous pousse à voir ce que vous voulez croire ? Cet article propose une feuille de route pour les dirigeants qui veulent transformer leurs données en un véritable levier de pilotage. Nous allons déconstruire les obstacles invisibles qui paralysent la prise de décision et fournir des méthodes concrètes pour faire de chaque chiffre un point de départ pour l’action.

Pour naviguer avec clarté dans cette transformation, nous aborderons les points essentiels qui permettent de passer de la confusion des données à une stratégie éclairée. Ce guide est structuré pour vous fournir des leviers d’action concrets à chaque étape.

Sommaire : Transformer la donnée brute en intelligence stratégique

- Pourquoi vos données marketing et commerciales se contredisent-elles systématiquement ?

- Comment transformer un tableau Excel imbuvable en graphique décisionnel clair ?

- Le risque de faire dire aux chiffres ce que vous avez envie d’entendre (Biais de confirmation)

- Data Warehouse ou CDP : quel outil pour centraliser la connaissance client ?

- Pilotage temps réel : quand est-il crucial d’avoir la donnée à la seconde près ?

- Comment créer un dashboard lisible en moins de 10 secondes par votre PDG ?

- Export BigQuery : pourquoi est-ce indispensable pour conserver votre historique au-delà de 14 mois ?

- Outils Google Analytics : configurer GA4 pour récupérer les données perdues par le consentement cookies

Pourquoi vos données marketing et commerciales se contredisent-elles systématiquement ?

Le point de départ de toute paralysie décisionnelle se trouve souvent dans ce que l’on pourrait appeler la « friction sémantique ». Le marketing célèbre une augmentation de 50% des « leads générés » grâce à une nouvelle campagne, tandis que l’équipe commerciale se plaint de recevoir des contacts non qualifiés. Les deux équipes regardent leurs chiffres, et les deux ont raison selon leur propre définition. Ce n’est pas un problème d’outil, mais de langage. Sans un dictionnaire de données commun, chaque département mesure le succès avec sa propre règle, rendant toute vision consolidée impossible.

Cette absence de gouvernance crée une « dette de données » silencieuse mais coûteuse. Au-delà des frustrations internes, une étude de Smartpoint révèle que cette situation génère une explosion du TCO et des risques réglementaires pour les directions des systèmes d’information. Chaque rapport contradictoire est une perte de temps, d’énergie et de crédibilité pour la fonction data. La première étape n’est donc pas technique, mais organisationnelle : forcer les équipes à parler la même langue.

La solution passe par la création d’un référentiel unique et partagé. Il s’agit d’organiser des ateliers de « synchronisation sémantique » où marketing et ventes définissent ensemble des métriques clés comme « Lead Qualifié Marketing » (MQL) ou « Opportunité Commerciale ». Ce travail, souvent perçu comme fastidieux, est le fondement de la confiance. Une fois ces définitions actées, elles doivent être implémentées dans les outils pour que tout le monde regarde le même chiffre, avec la même signification. Les organisations qui réussissent à industrialiser leurs usages de l’IA sont celles qui traitent leurs données comme des actifs critiques, avec une gouvernance claire.

Comment transformer un tableau Excel imbuvable en graphique décisionnel clair ?

Une fois les données fiables et unifiées, le second défi est de les rendre compréhensibles. Un export Excel de 10 000 lignes est une donnée brute, pas un insight. La différence est cruciale : une donnée est une observation, un insight est une observation contextualisée qui pousse à l’action. La transformation s’opère par la visualisation, mais pas n’importe laquelle. Le plus grand écueil est de vouloir tout montrer, créant des « sapins de Noël » visuels où l’information essentielle est noyée.

Le principe fondamental est simple : une bonne visualisation de données est un acte de soustraction, pas d’addition. Elle élimine le bruit pour ne laisser que le signal. Le choix du graphique, des couleurs et du niveau de détail doit être dicté par une seule question : « Quelle décision cette information doit-elle permettre de prendre ? ». Un graphique qui ne mène à aucune question ou action potentielle est un simple bruit visuel.

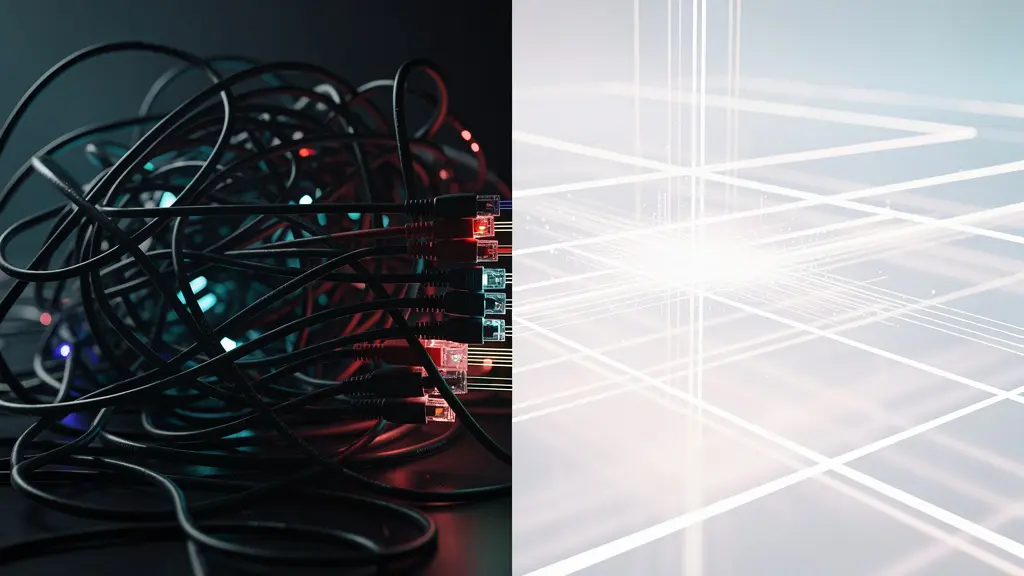

Comme le montre cette visualisation, l’objectif est de passer du chaos des chiffres bruts à la clarté d’un message limpide. L’audience est le facteur déterminant dans cet exercice de clarification. Un PDG, un manager et un analyste n’ont ni les mêmes besoins, ni le même temps disponible. Adapter la présentation de la donnée à son destinataire est la clé d’une communication efficace.

Ce tableau comparatif illustre comment adapter la granularité et le format des indicateurs en fonction de l’audience, une approche essentielle pour s’assurer que le message est non seulement vu, mais aussi compris et utilisé.

| Audience | Nombre de KPI max | Format idéal | Fréquence de mise à jour |

|---|---|---|---|

| PDG/Direction | 4-7 indicateurs | KPI unique grand format | Hebdomadaire |

| Manager | 5-10 indicateurs | Tendance évolutive | Quotidienne |

| Analyste | 10-15 indicateurs | Analyse comparative détaillée | Temps réel |

Le risque de faire dire aux chiffres ce que vous avez envie d’entendre (Biais de confirmation)

Même avec des données propres et des graphiques clairs, le principal obstacle à une décision juste reste l’instrument qui interprète ces données : le cerveau humain. Le biais de confirmation est le plus puissant et le plus dangereux des pièges pour un décideur. C’est notre tendance naturelle à rechercher, interpréter et mémoriser les informations qui confirment nos croyances ou hypothèses préexistantes, tout en ignorant celles qui les contredisent. Si vous êtes convaincu que votre dernière campagne est un succès, vous vous focaliserez sur le taux de clics en hausse et minimiserez la baisse du taux de conversion.

Cette tendance est un réflexe. L’antidote n’est pas de l’ignorer, mais d’instaurer des processus pour la neutraliser. La sagesse en matière de décision ne vient pas d’une intelligence supérieure, mais d’une hygiène cognitive rigoureuse. Comme le résume brillamment l’investisseur Charlie Munger :

C’est remarquable les avantages long terme que l’on obtient en cherchant constamment à ne pas être stupide plutôt que d’être très intelligent.

– Charlie Munger

Un exemple historique parfait est le biais du survivant, un cousin du biais de confirmation. Pendant la Seconde Guerre mondiale, les ingénieurs militaires voulaient renforcer les avions en blindant les zones les plus touchées par les impacts de balles sur les appareils qui revenaient de mission. Le statisticien Abraham Wald leur a fait remarquer l’erreur fondamentale : ils ne voyaient que les survivants. Les zones intactes sur ces avions étaient en réalité les plus vulnérables, car les appareils touchés à ces endroits ne revenaient jamais. En se concentrant sur les « succès » (les avions revenus), ils étaient sur le point de prendre une décision catastrophique. C’est exactement ce qui se passe quand on analyse les « clients qui convertissent » sans jamais étudier ceux qui abandonnent.

Pour combattre activement ces biais, il est nécessaire d’intégrer des garde-fous dans vos processus d’analyse. Il s’agit de créer une culture où le questionnement des certitudes est valorisé.

Plan d’action pour une analyse objective

- Technique du Pré-mortem : Avant de lancer un projet, imaginez qu’il a échoué lamentablement. Organisez une réunion pour identifier toutes les raisons possibles de cet échec en vous basant sur les données disponibles.

- Institutionnaliser un « Avocat du Diable » : Dans chaque revue de données, nommez une personne dont le rôle officiel est de challenger l’interprétation dominante et de trouver des données qui la contredisent.

- Documenter l’hypothèse AVANT l’analyse : Avant de plonger dans les chiffres, écrivez noir sur blanc l’hypothèse à tester. Cela empêche de « torturer » les données jusqu’à ce qu’elles avouent ce que vous voulez entendre.

- Analyser les échecs et les non-événements : Consacrez autant de temps à analyser pourquoi certains clients n’achètent pas qu’à étudier ceux qui achètent. Cherchez les « trous » dans les données, pas seulement les points.

- Confronter les sources de données : Mettez systématiquement en parallèle des données de sources différentes (ex: Analytics web vs Retours CRM) pour repérer les incohérences, qui sont souvent des mines d’insights.

Data Warehouse ou CDP : quel outil pour centraliser la connaissance client ?

Une fois la gouvernance et les biais adressés, la question de l’outil centralisateur devient pertinente. Deux acronymes dominent le paysage : le Data Warehouse (DWH) et la Customer Data Platform (CDP). Pour un décideur, la distinction peut sembler floue, mais leurs finalités sont radicalement différentes. Choisir le mauvais outil, c’est comme utiliser un marteau pour visser : c’est possible, mais inefficace et coûteux.

Le Data Warehouse est le coffre-fort historique de l’entreprise. C’est un système robuste, conçu pour stocker, agréger et analyser des volumes massifs de données structurées provenant de multiples sources (ERP, CRM, finance…). Sa vocation est la Business Intelligence (BI) : répondre à des questions complexes sur le passé pour dégager des tendances de fond. Il demande une forte expertise technique pour être mis en place et maintenu. La CDP, quant à elle, est un outil plus agile et orienté marketing. Son but premier est de créer un profil client unifié et de le rendre immédiatement « activable » par les équipes marketing (pour la personnalisation, le retargeting, l’emailing…). Elle est conçue pour être utilisée par des non-techniciens.

Le choix ne doit pas être guidé par la technologie, mais par la priorité stratégique de l’entreprise. Cherchez-vous à faire de l’analyse historique complexe ou à activer des audiences en temps réel ? La réponse à cette question oriente 80% de la décision. De plus, le contexte réglementaire, notamment avec l’entrée en application de l’AI Act européen, rend la maîtrise de la provenance et de l’usage des données plus critique que jamais, ce qui impacte l’architecture de votre système d’information.

Le tableau suivant offre un guide de décision rapide pour vous aider à arbitrer entre ces deux approches en fonction de vos priorités métier.

| Critère | Data Warehouse | CDP |

|---|---|---|

| Priorité d’usage | Analyse historique complexe et BI | Activation d’audience en temps réel |

| Compétences requises | Équipe technique (data engineers) | Accessible aux marketeurs |

| Coût de maintenance | Élevé (infrastructure + équipe) | Modéré (solution packagée) |

| Flexibilité | Totale (custom) | Limitée aux cas d’usage prévus |

| Tendance 2024-2025 | Base pour Composable CDP | Évolution vers l’hybride |

Pilotage temps réel : quand est-il crucial d’avoir la donnée à la seconde près ?

Le « temps réel » est l’un des buzzwords les plus persistants dans le monde de la data. L’idée de piloter son activité à la seconde près est séduisante, mais elle est souvent un luxe coûteux et, dans bien des cas, inutile. L’obsession pour le temps réel peut même être contre-productive, en noyant les décideurs sous un flux constant de micro-variations sans signification statistique. La vraie question n’est pas « Pouvons-nous avoir la donnée en temps réel ? », mais « Avons-nous besoin de décider en temps réel ? ».

Il faut distinguer le « temps réel » du « temps juste ». Le temps juste est le délai de mise à jour optimal qui permet de prendre la bonne décision au bon moment, sans surcoût inutile. Pour une décision stratégique (ex: réallouer un budget marketing trimestriel), une donnée hebdomadaire est largement suffisante. Pour un système de détection de fraude bancaire, la milliseconde est critique. Pour un manager qui suit la performance de son équipe, une mise à jour quotidienne est souvent le « temps juste ».

L’enjeu est de qualifier la vélocité nécessaire pour chaque type de décision. Le coût d’infrastructure et de maintenance d’un système temps réel est exponentiel. Le justifier par un ROI tangible est un prérequis. Au lieu de viser le « temps réel » partout, cartographiez vos décisions et attribuez à chacune sa propre temporalité.

Pour déterminer le « temps juste » pour chaque cas d’usage, posez-vous les quatre questions suivantes. Cette matrice simple vous aidera à distinguer les besoins critiques des optimisations superflues.

- La décision est-elle automatisée ou humaine ? Les machines (ex: algorithmes de trading) ont besoin de temps réel. Les humains ont besoin de temps pour la réflexion ; un flux constant est une distraction.

- Quelle est la fréquence de changement notable des données ? Si votre stock change toutes les secondes, le temps réel est pertinent. Si vos ventes sont lissées sur la journée, une mise à jour horaire est suffisante.

- Quel est l’impact d’une décision retardée de 1 heure ? Si l’impact est critique (ex: rupture de chaîne logistique), le temps réel est justifié. S’il est modéré ou négligeable, le coût n’en vaut pas la peine.

- Le coût du temps réel est-il justifié par le ROI ? Comparez l’investissement en infrastructure et en compétences au gain opérationnel attendu. Souvent, 80% du gain est atteint avec une mise à jour quotidienne.

Comment créer un dashboard lisible en moins de 10 secondes par votre PDG ?

Le tableau de bord destiné à la direction générale est l’épreuve du feu de votre stratégie data. C’est là que la complexité doit s’effacer au profit d’une clarté absolue. Un dirigeant n’a pas le temps de déchiffrer des graphiques complexes ou de naviguer entre dix onglets. Il doit pouvoir, en un coup d’œil, répondre à une seule question : « Sommes-nous sur la bonne voie ? ». Si votre dashboard ne répond pas à cette question en moins de 10 secondes, il a échoué.

Le principal ennemi de la clarté est le « paradoxe du choix » : en voulant tout montrer, on ne montre rien. La solution est une discipline de fer dans la sélection des indicateurs. Les experts recommandent d’afficher entre 5 et 10 KPI maximum par tableau de bord. Pour un dashboard de direction, 4 ou 5 suffisent amplement. Chaque KPI doit être directement lié à un objectif stratégique de l’entreprise (ex: croissance, rentabilité, satisfaction client).

L’approche la plus efficace est souvent la plus simple. Une PME peut retrouver une lecture limpide de sa performance avec un tableau de bord épuré, connecté aux sources fiables (CRM, ERP), qui présente quelques indicateurs clés. L’automatisation est non négociable : un tableau de bord mis à jour à la main finit toujours par être abandonné. La clé est la confiance et la régularité. Tout le monde doit regarder les mêmes chiffres, au même moment.

Pour construire un dashboard « lisible en 10 secondes », suivez ces trois principes de design :

- Hiérarchie visuelle forte : Le KPI le plus important (ex: le chiffre d’affaires) doit être le plus grand, en haut à gauche. Utilisez la taille et la couleur pour guider l’œil.

- Le contexte est roi : Un chiffre seul ne veut rien dire. 42 000€ de MRR, est-ce bon ou mauvais ? Chaque KPI doit être accompagné d’un contexte : une comparaison avec l’objectif, avec le mois précédent ou avec l’année précédente.

- La tendance prime sur la valeur brute : Une mini-courbe (sparkline) à côté d’un chiffre est souvent plus parlante que le chiffre lui-même. Elle indique instantanément la dynamique en cours.

Export BigQuery : pourquoi est-ce indispensable pour conserver votre historique au-delà de 14 mois ?

Utiliser Google Analytics 4 (GA4) sans exporter les données brutes, c’est comme louer un appartement magnifique sans jamais en devenir propriétaire. Vous profitez de la vue, mais vous n’accumulez aucun patrimoine. Par défaut, GA4 ne conserve les données détaillées au niveau utilisateur (ex: le parcours d’un visiteur spécifique) que pour une durée maximale de 14 mois. Passé ce délai, ces informations granulaires sont perdues à jamais, ne laissant que des données agrégées.

Cette limitation n’est pas un détail technique, c’est un enjeu stratégique majeur. Comment calculerez-vous la Valeur Vie Client (LTV) sur 3 ans ? Comment analyserez-vous la saisonnalité de vos ventes d’une année sur l’autre avec précision ? Sans cet historique, vous pilotez à vue, incapable de mener des analyses longitudinales complexes. L’export natif et gratuit de GA4 vers Google BigQuery (un Data Warehouse dans le cloud) est la seule solution pour briser cette contrainte.

Cet export change fondamentalement votre rapport à la donnée. En la stockant dans votre propre projet BigQuery, vous en devenez réellement propriétaire. Comme le souligne un expert en souveraineté des données :

Tant que les données sont dans l’UI de Google, on les ‘loue’. En les exportant dans son propre projet BigQuery, l’entreprise en devient réellement propriétaire.

– Expert en souveraineté des données

Devenir propriétaire de vos données ouvre des possibilités d’analyse inaccessibles depuis l’interface standard de GA4. Vous pouvez croiser vos données de navigation avec vos données CRM pour calculer un ROI précis par canal, analyser des séquences d’utilisateurs complexes sur plusieurs années, ou encore construire des modèles d’attribution sur-mesure. Mettre en place cet export est un investissement minime pour une assurance stratégique maximale : celle de maîtriser votre actif le plus précieux, votre historique de données.

À retenir

- Une donnée n’est pas un insight. La valeur réside dans l’interprétation, le contexte et la question métier à laquelle elle répond.

- La gouvernance des données (des définitions partagées entre les équipes) est le prérequis non-négociable à toute analyse fiable et à toute décision sereine.

- Le meilleur tableau de bord est celui qui répond à une question précise avec un minimum de chiffres, pas celui qui submerge l’utilisateur sous le volume.

Outils Google Analytics : configurer GA4 pour récupérer les données perdues par le consentement cookies

Dans un monde post-cookies tiers et régi par le RGPD, collecter des données exhaustives est devenu un défi majeur. Le bandeau de consentement n’est plus une simple formalité : chaque « Refuser » crée un trou dans votre collecte de données. Pour un décideur, cela signifie que les chiffres présentés dans les rapports sont de plus en plus partiels et potentiellement trompeurs. Ignorer ce phénomène, c’est accepter de piloter avec une vision déformée de la réalité.

Google a mis en place une solution pour pallier ce manque : le Consent Mode v2. Son principe est d’envoyer des « pings » anonymes et agrégés à Google même lorsqu’un utilisateur refuse les cookies. Ces signaux sans identifiant permettent aux algorithmes de Google de modéliser les conversions et le comportement des utilisateurs non-consentants, comblant ainsi une partie des données perdues. Depuis mars 2024, l’implémentation du Consent Mode v2 est devenue obligatoire pour continuer à utiliser les fonctionnalités de personnalisation publicitaire de Google Ads. Ne pas l’adopter, c’est donc non seulement perdre en visibilité, mais aussi s’exposer à une dégradation de la performance publicitaire.

Cependant, pour aller plus loin et reprendre un contrôle maximal sur la qualité des données, une approche plus stratégique émerge : le Server-Side Tagging (sGTM). Au lieu d’envoyer les données directement du navigateur de l’utilisateur vers Google, elles sont d’abord envoyées vers un serveur que vous contrôlez. Ce serveur agit comme un filtre : il nettoie, enrichit et anonymise les données avant de les transmettre aux plateformes tierces (Google, Facebook, etc.). Cette approche n’est pas qu’un outil technique. C’est une démarche stratégique qui permet d’augmenter la qualité des données first-party, d’améliorer la performance du site (en allégeant le navigateur) et de préparer sereinement un avenir sans cookies tiers.

Pour transformer ces principes en une feuille de route concrète et efficace, l’étape suivante consiste à réaliser un audit de votre maturité data afin d’identifier les chantiers prioritaires pour votre organisation.